ilk yerli llm projesi. göründüğü kadarıyla epey hızlı.

ancak herhangi bir reasoning işlemi yok, internete bağlanamıyor. dümdüz llm yapıyor.

şimdilik pek kullanılacak gibi değil.

kendileri şöyle yazmışlar sitelerinde:

kumru, vngrs tarafından türkçe için sıfırdan geliştirilmiş ve eğitilmiş ilk temel dil modelidir. 7.4 milyar parametreye sahiptir. zengin ve güncel kaynaklardan beslenen 500 gb'lık temizlenmiş, tekilleştirilmiş bir veriseti ile 300 milyar token eğitilen model 8,192 token'lık bir context length'e sahiptir. tokenizer'ı da türkçe için sıfırdan eğitildiği için verilen metni tokenize ederken llama-3, gpt-4o gibi multilingual tokenizer'lara göre %40 ile %90 arasında daha az token harcar. bu yüzden de efektif olarak 12k'ya yakın bir context length'e sahiptir. cetvel türkçe llm benchmark'ında llama-3.3-70b, qwen-2-72b, gemma-3-27b, aya-32b gibi kendisinden çok daha büyük açık kaynak modellerden daha yüksek skorlar almıştır. model, verimliliği sayesinde 16 gb vram'e sahip gpu'larda quantization gibi tekniklere gerek duyulmaksızın kurum içi yerinde kullanıma uygundur.

adres:

https://kumru.ai/

14 favorites - isp - 10.10.2025 18:11

matematik konusunda inanılmaz yetenekli bir yapay zeka.

3+3x5 işleminin sonucunun 9 olduğunu iddia ediyor.

3+3x5 işleminin sonucunun 9 olduğunu iddia ediyor.

8 favorites - invincebleisnothing - 10.10.2025 18:50

son kullanıcı odaklı bir genel sohbet botu olmaktan ziyade, b2b çözümler için tasarlanmış bir model.

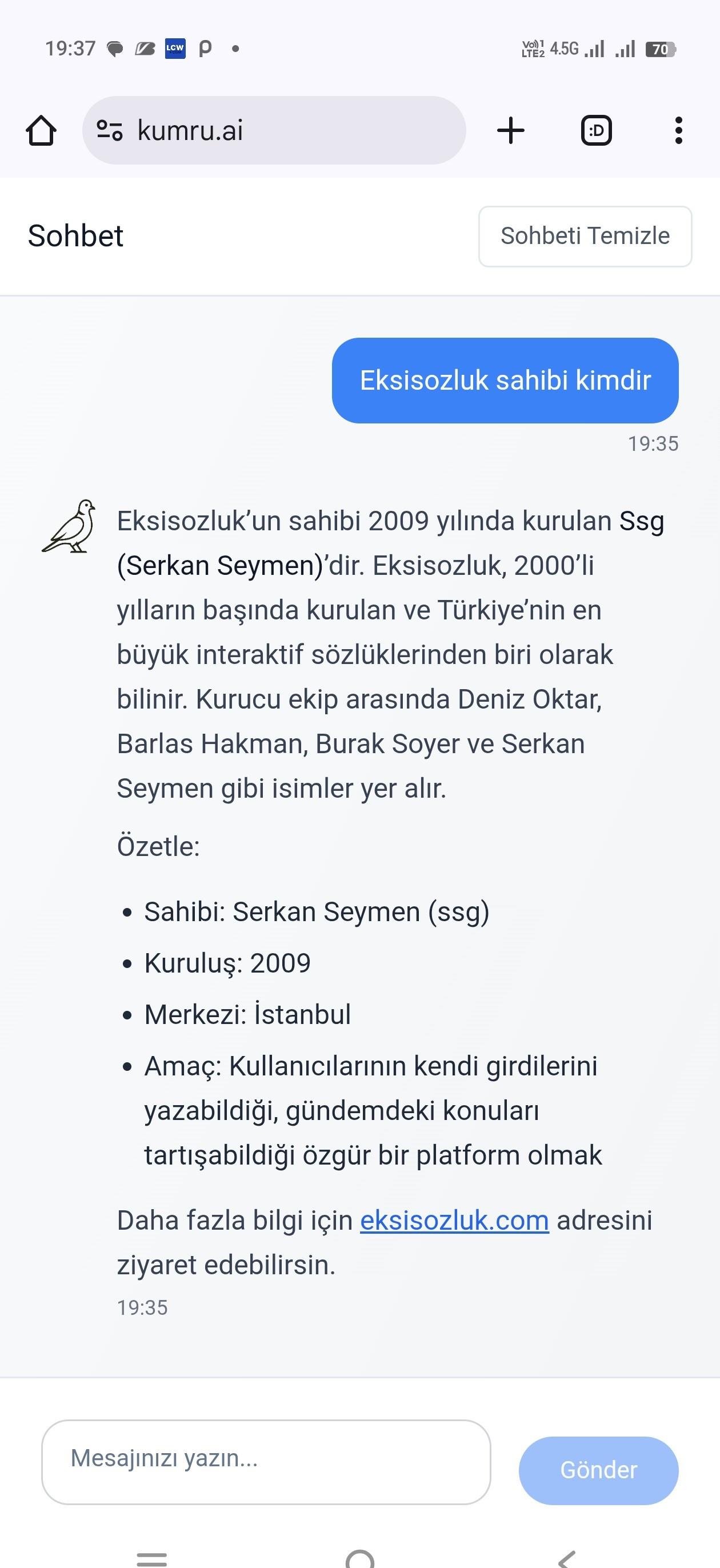

görsel

görsel

3 favorites - kelimemuslugu - 10.10.2025 20:06

yalnız... yanlış bilgi veriyor bu yav? matematik işlem önceliği konusunda şöyle diyor haşmetmeap:

"tabii, matematikte işlemlerin öncelik sırası çok önemlidir. işlemler şu sırayla yapılır:

toplama ve çıkarma: önce toplama ve çıkarma işlemleri yapılır.

çarpma ve bölme: toplama ve çıkarma işleminden sonra gelir.

karekök alma: çarpma ve bölmeden sonra yapılır.

üs alma: toplama ve çıkarmadan sonra gelir.

faktöriyel: üs ve karekökten sonra yapılır.

oran-orantı çözümleri: bu işlemler toplama-çıkarma ile karıştırılmamalıdır; önce toplama ve çıkarma, sonra diğer işlemler yapılır.

eksik veya fazla toplama/çıkarma: son işlemlerde toplama veya çıkarmada hata olursa işlemi başa alırsın.

kısacası:

önce toplama ve çıkarma, sonra çarpma ve bölme, ardından diğer işlemler gelir.

karekök alma genellikle son işlemdir çünkü çarpma ve bölme işlemlerinden sonra yer alır.

matematikte işlemlerin sırası bu şekilde özetlenebilir!"

yani özetlenir ve önemlidir de kumrucum, yanlış özetliyosun.

"tabii, matematikte işlemlerin öncelik sırası çok önemlidir. işlemler şu sırayla yapılır:

toplama ve çıkarma: önce toplama ve çıkarma işlemleri yapılır.

çarpma ve bölme: toplama ve çıkarma işleminden sonra gelir.

karekök alma: çarpma ve bölmeden sonra yapılır.

üs alma: toplama ve çıkarmadan sonra gelir.

faktöriyel: üs ve karekökten sonra yapılır.

oran-orantı çözümleri: bu işlemler toplama-çıkarma ile karıştırılmamalıdır; önce toplama ve çıkarma, sonra diğer işlemler yapılır.

eksik veya fazla toplama/çıkarma: son işlemlerde toplama veya çıkarmada hata olursa işlemi başa alırsın.

kısacası:

önce toplama ve çıkarma, sonra çarpma ve bölme, ardından diğer işlemler gelir.

karekök alma genellikle son işlemdir çünkü çarpma ve bölme işlemlerinden sonra yer alır.

matematikte işlemlerin sırası bu şekilde özetlenebilir!"

yani özetlenir ve önemlidir de kumrucum, yanlış özetliyosun.

0 favorites - darksoul - 10.10.2025 20:15

benimde lokalde hazır llmleri alıp fine tuning yaptığım dil modelim var. hatta mühendislik hesabı için yazılmış python tool ları çağırıp çalıştırabiliyor ve internete bağlanabiliyor. üstelik bunu flask ile bir html arayüzüne de bağladım ki şık da görünüyor. bilgisayardaki dosyaları okuyup bilgisayar üzerinde işlem yapabiliyor.

ama türkiye'nin ilk yapay zekası diye sunmuyorum. çünkü değil. bu işlerle uğraşan on binlerce kişi var ve hepsinin rag, fine tune yaptığı kendi modeli var. hatta bunları pull da edebilirsiniz. akıllının biri çıkmış yapay zeka yaptım demiş.

edit: llm in kendine de sorabilirsiniz. mistral ve llama-3'ün merge edilmiş hali.

ama türkiye'nin ilk yapay zekası diye sunmuyorum. çünkü değil. bu işlerle uğraşan on binlerce kişi var ve hepsinin rag, fine tune yaptığı kendi modeli var. hatta bunları pull da edebilirsiniz. akıllının biri çıkmış yapay zeka yaptım demiş.

edit: llm in kendine de sorabilirsiniz. mistral ve llama-3'ün merge edilmiş hali.

21 favorites - anox - 10.10.2025 20:21 ~ 20:25

"ilk yerli llm projesi" iddiasına götünüzle gülebilirsiniz. her bilgisayar mühendisliği bölümünün bitirme projelerinde bile benzer llm ler yapılmaktadır.

2 favorites - summerof69 - 10.10.2025 20:21

modelin mistral mimarisine dayanıyor olması kafaları karıştırmış. modelin mimarisinin mistral olması ile sıfırdan eğitilmesi çelişen şeyler değil.

kumru'nun medium post'unda da anlatılmış.

https://medium.com/vngrs/kumru-llm-34d1628cfd93

edit: hakkında'ya sık sorulan sorulara cevaplar bölümü eklemişler.

https://kumru.ai/hakkinda

1) kumru son kullanıcılara (b2c) yönelik bir ürün mü?

hayır. bu, kurum-içi kurumsal kullanım (b2b) için geliştirilmiş bir ürün.

2) neden boyle bir modele ihtiyaç var?

türkiye’de özellikle finans gibi sektörlerde faaliyet gösteren pek çok kurum, veri güvenliğine dair regülasyonlar sebebiyle chatgpt gibi hizmetleri kullanamıyor. kurum-içi (on-premise) kullanılabilecek açık dil modellerinden büyük olanların gereksinim duyduğu donanım yatırım maliyeti yüksek, küçük olanların ise türkçe yetenekleri yetersiz çünkü türkçe, bu modellerin ana dili değil. biz de buradaki bu açığı doldurmak için, büyük donanım yatırımları gerektirmeden çalışabilecek, ana dili türkçe olan kumru modelini eğittik.

3) kumru, chatgpt’ye rakip mi?

hayır. chatgpt hem b2c hem b2b için konumlandırılmış devasa bir model ailesi iken, kumru türkiye içindeki kurum-içi çözümler için geliştirilmiş, küçük, hızlı ve ucuz bir çözüm.

4) verdiği bilgilerde neden hata yapabiliyor?

yapay zeka modellerine dair çözülmesi en zorlu problemlerden biri hatalı bilgi vermesi, yani halüsinasyonlar. yapay zeka eğitilirken farklı aşamalardan geçiyor ve son aşama olan pekiştirmeli öğrenme (reinforcement learning from human feedback) ile bu halüsinasyonlar en aza indirgeniyor. openaı’ın chatgpt’den önce 2022 başında sunduğu davinci-001 modeli de pekiştirmeli öğrenme aşamasından henüz geçmemişti ve bu yüzden bol miktarda halüsinasyon görüyordu. kumru da, aynı davinci-001 modeli gibi, henüz pekiştirmeli öğrenme aşamasından geçmediği için hatalı bilgiler verebiliyor.

5) sıfırdan geliştirilen model ne demek?

daha önce hiçbir veriye maruz kalmamış bir yapay zeka modelinin sıfırdan inşa edilip tüm eğitim süreçlerinden geçirilip eğitilmesi anlamına geliyor. yani boş bir arsa alıp üstüne kaba mimari plani olan bir binayı, istediğiniz malzemeyi kullanarak, detay tasarım kararlarını vererek sıfırdan inşa etmeye benziyor.

bunun alternatifi; llama, gemma, qwen gibi aynı anda pek çok dilde eğitilmiş modelleri alıp istenen dilde ya da alanda bir miktar daha eğitmek ve ince ayar yapmak. bu da hazır bir binayı alıp renove etmeye benzetilebilir, ancak bunun da dezavantajları var ve biz de bu sebeple ilkini seçtik.

6) model mimarisi nedir? mistral ne demek?

model mimarisi,derin öğrenme (deep learning) modelini oluşturan katmanların (layer) ne tür olduğunu ve hangi sırayla kullanıldığını tanımlamak için kullanılıyor.

arsa ve bina benzetmesinden gidersek, mistral, binanın kaba mimarisinin nasıl olduğunu tanımlıyor, örn: bahçeli bir müstakil ev.

7) kumru’nun güçlü ve zayıf olduğu işler neler?

kumru, yaratıcı yazım işlerinde daha başarılı. ona sağlanan metin ve dökümanları anlayıp özetlemek, soru cevaplamak, başka şekilde yeniden yazmak, başlık atmak, etiketlemek, tasnif etmek gibi işler için çok uygun ve kendisinden daha büyük llama ve gemma gibi açık modellerden daha başarılı.

ezbere dayalı sorularda daha zayıf çünkü küçük bir model (7.4 milyar parametre) olmasına bağlı kapasitesi -hafızası- sınırlı. matematikte kötü çünkü pekiştirmeli öğrenme aşamasından geçmedi. kodlama biliyor, ama bu konudaki eğitim verisi sınırlı olduğu için bu konuda iddialı değil.

8) kumru matematikte neden kötü?

dil modelleri, kelime ve kelimeciklerden (token) oluşan metinleri işler ve üretirler. bildiklerini ise eğitildikleri devasa metin derlemlerinden istatistiki olarak öğrenirler. kendi içlerinde bir hesap makinesi mekanizmasına da sahip değiller. tüm bunların sonucu matematik işlemleri yapmayı bilmeyen, ancak neyi bilip bilmediğini de bilmeyen, o yüzden de konu matematiğe gelince bolca hata yapan geveze bir ürün.

chatgpt ve benzeri erken modeller de ilk zamanlarda çok fazla matematik hatası yapıyordu. ilerleyen yıllarda gelişmiş pekiştirmeli öğrenme yöntemleri ile mevcut yeteneklerine kavuştular. kumru da benzer şekilde pekiştirmeli öğrenme aşamasından geçtikten sonra matematikte daha başarılı olacak.

9) verdiğim kelimedeki harfleri sorunca yanlış cevap veriyor, neden?

popüler dil modelleri için işledikleri metindeki en küçük birim kelime ya da kelimeciktir, buna token diyoruz. bu sebeple, bir metni işlerken onu oluşturan karakterleri görmezler. bu sebeple de verilen kelimeyi oluşturan harflere dair bir soru sorulduğunda sıklıkla hata yaparlar. 2024 yılında chatgpt gibi modellere “strawberry” kelimesinde kaç adet r harfi olduğunu sormak popüler bir benchmark haline gelmişti ve en iyi modeller dahi hata yapıyordu.

10) 2 milyar ile 7 milyar arasındaki fark nedir?

eğitim verisi, bağlam uzunluğu (context length) ve tokenizer açısından iki model de birebir aynı spesifikasyonlara sahip. tek fark modellerin boyutları. dil modellerinin kabiliyetleri ve hafızaları, sahip oldukları parametre sayısıyla paralellik gösterdiği için büyük model daha çok biliyor ve daha hünerli diyebiliriz.

11) model, daha önceden eğitilmiş bir mistral ya da llama üzerine ince ayar yapılarak mı elde edildi?

hayır! model mimarisinin mistral olması, önden eğitilmiş (pre-trained) bir mistral modelinin alınıp eğitilmeye devam edildiği (continual pre-training) ya da ince ayar (fine-tuning) yapıldığı anlamına gelmiyor.

kumru, tokenizer’ı ve model weight’leri ile uçtan uca tamamen sıfırdan yaratıldı ve eğitildi.

12) llama gibi bir modeli continual pre-training yapmak yerine neden sıfırdan eğittiniz?

continual pre-training gayet makul bir strateji ve türkiye’deki pek çok grup da bunu yapıyor. ancak dezavantajı, orijinal modelin tokenizer’ının kullanılmasını gerektirmesi. bu da hem eğitim esnasında, hem de kullanım esnasında metinler işlenirken, türkçe bir tokenizer’a göre daha fazla token harcanması ile sonuçlanıyor. netice olarak modeli eğitme ve kullanma maliyeti ve süresi 2 katına kadar artıyor.

pre-trained bir modelin embedding matrix’ini ve tokenizer’ını ameliyat edip türkçe’ye uyarlamak mümkün, ama bu da yalnızca bir yere kadar etkili, ve model ile tokenizer arasındaki bağı koparmış oluyorsunuz.

biz bunun yerine türkçe’nin ihtiyaçlarını da göz önünde bulundurarak pretokenization regex’i, kod ve matematik desteği de olan ve tüm dizayn kararlarını bilinçli bir şekilde verdiğimiz modern bir türkçe llm tokenizer’ı geliştirmeyi ve kumru’yu bununla eğitmeyi seçtik. tüm bu adımları baştan sona yapmanın getirdiği tecrübeye bağlı bilgi birikimi de cabası.

13) mimari olarak neden llama, gemma, qwen gibi alternatifler varken neden mistral seçtiniz?

projeye 2024 ortasında başladığımız zamanlarda açık-kaynak modellerde llama ve mistral başı çekiyordu. özellikle mistral, sliding window teknolojisi ile başlarda özellikle uzun bağlama sahip metinleri işler ve üretirken çok başarılı görünüyordu. llama modeli ise, yayınladığı detaylı teknik raporlarla bir büyük dil modelinin uçtan uca nasıl eğitildiği konusuna ışık tutuyordu. mistral modeli, v0.3 ile sliding window teknolojisini artık kullanmamaya karar verdi çünkü uzun bağlamlarda hatalara sebep olduğu fark edildi. bu fark ortadan kalkınca mistral v0.3 ile llama-3 mimarileri birebir aynı hale geldi. dolayısıyla mistral seçimimiz bu iki modelin başarısına, birbirlerinin tıpatıp aynısı olmalarına ve geliştirme sürecine ışık tutan llama-3 teknik makalesine dayanıyor.

14) hangi verileri kullandınız?

içerikleri mart 2024 tarihine dek üretilmiş türkçe web derlem başta olmak üzere wikipedia, haber metinleri gibi literatürdeki veriler ile %5 oranında da ingilizce web ve kod derlemlerini kullandık.

15) geliştirme haritanız nasıl?

ilk hedefimiz modelin yaptığı hataları en aza indirmek için pekiştirmeli öğrenme aşamasından geçirmek. paralelde görselleri ve taratılmış dökümanları işleme kabiliyeti kazandırarak kumru’yu multimodal bir model haline getirmek için bir image encoder entegrasyonunu çalışıyoruz.

bunun yanında kumru’nun daha büyük ve maharetli versiyonlarını da daha büyük ve güncel verisetleri ile eğitmeyi planlıyoruz.

şu anda openaı’ın 2022 başında duyurduğu davinci-001 modeli ile aynı aşamadayız. o yüzden openaı’ın gpt modellerinin ayak izlerini takip ederek ilerliyoruz diyebiliriz.

16) 7 milyarlık modeli de açık kaynak yayınlayacak mısınız?

daha büyük ve multimodal modeller ürettikçe 7 milyarlık versiyondan başlayarak eski modelleri yayınlamayı planlıyoruz.

kumru'nun medium post'unda da anlatılmış.

https://medium.com/vngrs/kumru-llm-34d1628cfd93

edit: hakkında'ya sık sorulan sorulara cevaplar bölümü eklemişler.

https://kumru.ai/hakkinda

1) kumru son kullanıcılara (b2c) yönelik bir ürün mü?

hayır. bu, kurum-içi kurumsal kullanım (b2b) için geliştirilmiş bir ürün.

2) neden boyle bir modele ihtiyaç var?

türkiye’de özellikle finans gibi sektörlerde faaliyet gösteren pek çok kurum, veri güvenliğine dair regülasyonlar sebebiyle chatgpt gibi hizmetleri kullanamıyor. kurum-içi (on-premise) kullanılabilecek açık dil modellerinden büyük olanların gereksinim duyduğu donanım yatırım maliyeti yüksek, küçük olanların ise türkçe yetenekleri yetersiz çünkü türkçe, bu modellerin ana dili değil. biz de buradaki bu açığı doldurmak için, büyük donanım yatırımları gerektirmeden çalışabilecek, ana dili türkçe olan kumru modelini eğittik.

3) kumru, chatgpt’ye rakip mi?

hayır. chatgpt hem b2c hem b2b için konumlandırılmış devasa bir model ailesi iken, kumru türkiye içindeki kurum-içi çözümler için geliştirilmiş, küçük, hızlı ve ucuz bir çözüm.

4) verdiği bilgilerde neden hata yapabiliyor?

yapay zeka modellerine dair çözülmesi en zorlu problemlerden biri hatalı bilgi vermesi, yani halüsinasyonlar. yapay zeka eğitilirken farklı aşamalardan geçiyor ve son aşama olan pekiştirmeli öğrenme (reinforcement learning from human feedback) ile bu halüsinasyonlar en aza indirgeniyor. openaı’ın chatgpt’den önce 2022 başında sunduğu davinci-001 modeli de pekiştirmeli öğrenme aşamasından henüz geçmemişti ve bu yüzden bol miktarda halüsinasyon görüyordu. kumru da, aynı davinci-001 modeli gibi, henüz pekiştirmeli öğrenme aşamasından geçmediği için hatalı bilgiler verebiliyor.

5) sıfırdan geliştirilen model ne demek?

daha önce hiçbir veriye maruz kalmamış bir yapay zeka modelinin sıfırdan inşa edilip tüm eğitim süreçlerinden geçirilip eğitilmesi anlamına geliyor. yani boş bir arsa alıp üstüne kaba mimari plani olan bir binayı, istediğiniz malzemeyi kullanarak, detay tasarım kararlarını vererek sıfırdan inşa etmeye benziyor.

bunun alternatifi; llama, gemma, qwen gibi aynı anda pek çok dilde eğitilmiş modelleri alıp istenen dilde ya da alanda bir miktar daha eğitmek ve ince ayar yapmak. bu da hazır bir binayı alıp renove etmeye benzetilebilir, ancak bunun da dezavantajları var ve biz de bu sebeple ilkini seçtik.

6) model mimarisi nedir? mistral ne demek?

model mimarisi,derin öğrenme (deep learning) modelini oluşturan katmanların (layer) ne tür olduğunu ve hangi sırayla kullanıldığını tanımlamak için kullanılıyor.

arsa ve bina benzetmesinden gidersek, mistral, binanın kaba mimarisinin nasıl olduğunu tanımlıyor, örn: bahçeli bir müstakil ev.

7) kumru’nun güçlü ve zayıf olduğu işler neler?

kumru, yaratıcı yazım işlerinde daha başarılı. ona sağlanan metin ve dökümanları anlayıp özetlemek, soru cevaplamak, başka şekilde yeniden yazmak, başlık atmak, etiketlemek, tasnif etmek gibi işler için çok uygun ve kendisinden daha büyük llama ve gemma gibi açık modellerden daha başarılı.

ezbere dayalı sorularda daha zayıf çünkü küçük bir model (7.4 milyar parametre) olmasına bağlı kapasitesi -hafızası- sınırlı. matematikte kötü çünkü pekiştirmeli öğrenme aşamasından geçmedi. kodlama biliyor, ama bu konudaki eğitim verisi sınırlı olduğu için bu konuda iddialı değil.

8) kumru matematikte neden kötü?

dil modelleri, kelime ve kelimeciklerden (token) oluşan metinleri işler ve üretirler. bildiklerini ise eğitildikleri devasa metin derlemlerinden istatistiki olarak öğrenirler. kendi içlerinde bir hesap makinesi mekanizmasına da sahip değiller. tüm bunların sonucu matematik işlemleri yapmayı bilmeyen, ancak neyi bilip bilmediğini de bilmeyen, o yüzden de konu matematiğe gelince bolca hata yapan geveze bir ürün.

chatgpt ve benzeri erken modeller de ilk zamanlarda çok fazla matematik hatası yapıyordu. ilerleyen yıllarda gelişmiş pekiştirmeli öğrenme yöntemleri ile mevcut yeteneklerine kavuştular. kumru da benzer şekilde pekiştirmeli öğrenme aşamasından geçtikten sonra matematikte daha başarılı olacak.

9) verdiğim kelimedeki harfleri sorunca yanlış cevap veriyor, neden?

popüler dil modelleri için işledikleri metindeki en küçük birim kelime ya da kelimeciktir, buna token diyoruz. bu sebeple, bir metni işlerken onu oluşturan karakterleri görmezler. bu sebeple de verilen kelimeyi oluşturan harflere dair bir soru sorulduğunda sıklıkla hata yaparlar. 2024 yılında chatgpt gibi modellere “strawberry” kelimesinde kaç adet r harfi olduğunu sormak popüler bir benchmark haline gelmişti ve en iyi modeller dahi hata yapıyordu.

10) 2 milyar ile 7 milyar arasındaki fark nedir?

eğitim verisi, bağlam uzunluğu (context length) ve tokenizer açısından iki model de birebir aynı spesifikasyonlara sahip. tek fark modellerin boyutları. dil modellerinin kabiliyetleri ve hafızaları, sahip oldukları parametre sayısıyla paralellik gösterdiği için büyük model daha çok biliyor ve daha hünerli diyebiliriz.

11) model, daha önceden eğitilmiş bir mistral ya da llama üzerine ince ayar yapılarak mı elde edildi?

hayır! model mimarisinin mistral olması, önden eğitilmiş (pre-trained) bir mistral modelinin alınıp eğitilmeye devam edildiği (continual pre-training) ya da ince ayar (fine-tuning) yapıldığı anlamına gelmiyor.

kumru, tokenizer’ı ve model weight’leri ile uçtan uca tamamen sıfırdan yaratıldı ve eğitildi.

12) llama gibi bir modeli continual pre-training yapmak yerine neden sıfırdan eğittiniz?

continual pre-training gayet makul bir strateji ve türkiye’deki pek çok grup da bunu yapıyor. ancak dezavantajı, orijinal modelin tokenizer’ının kullanılmasını gerektirmesi. bu da hem eğitim esnasında, hem de kullanım esnasında metinler işlenirken, türkçe bir tokenizer’a göre daha fazla token harcanması ile sonuçlanıyor. netice olarak modeli eğitme ve kullanma maliyeti ve süresi 2 katına kadar artıyor.

pre-trained bir modelin embedding matrix’ini ve tokenizer’ını ameliyat edip türkçe’ye uyarlamak mümkün, ama bu da yalnızca bir yere kadar etkili, ve model ile tokenizer arasındaki bağı koparmış oluyorsunuz.

biz bunun yerine türkçe’nin ihtiyaçlarını da göz önünde bulundurarak pretokenization regex’i, kod ve matematik desteği de olan ve tüm dizayn kararlarını bilinçli bir şekilde verdiğimiz modern bir türkçe llm tokenizer’ı geliştirmeyi ve kumru’yu bununla eğitmeyi seçtik. tüm bu adımları baştan sona yapmanın getirdiği tecrübeye bağlı bilgi birikimi de cabası.

13) mimari olarak neden llama, gemma, qwen gibi alternatifler varken neden mistral seçtiniz?

projeye 2024 ortasında başladığımız zamanlarda açık-kaynak modellerde llama ve mistral başı çekiyordu. özellikle mistral, sliding window teknolojisi ile başlarda özellikle uzun bağlama sahip metinleri işler ve üretirken çok başarılı görünüyordu. llama modeli ise, yayınladığı detaylı teknik raporlarla bir büyük dil modelinin uçtan uca nasıl eğitildiği konusuna ışık tutuyordu. mistral modeli, v0.3 ile sliding window teknolojisini artık kullanmamaya karar verdi çünkü uzun bağlamlarda hatalara sebep olduğu fark edildi. bu fark ortadan kalkınca mistral v0.3 ile llama-3 mimarileri birebir aynı hale geldi. dolayısıyla mistral seçimimiz bu iki modelin başarısına, birbirlerinin tıpatıp aynısı olmalarına ve geliştirme sürecine ışık tutan llama-3 teknik makalesine dayanıyor.

14) hangi verileri kullandınız?

içerikleri mart 2024 tarihine dek üretilmiş türkçe web derlem başta olmak üzere wikipedia, haber metinleri gibi literatürdeki veriler ile %5 oranında da ingilizce web ve kod derlemlerini kullandık.

15) geliştirme haritanız nasıl?

ilk hedefimiz modelin yaptığı hataları en aza indirmek için pekiştirmeli öğrenme aşamasından geçirmek. paralelde görselleri ve taratılmış dökümanları işleme kabiliyeti kazandırarak kumru’yu multimodal bir model haline getirmek için bir image encoder entegrasyonunu çalışıyoruz.

bunun yanında kumru’nun daha büyük ve maharetli versiyonlarını da daha büyük ve güncel verisetleri ile eğitmeyi planlıyoruz.

şu anda openaı’ın 2022 başında duyurduğu davinci-001 modeli ile aynı aşamadayız. o yüzden openaı’ın gpt modellerinin ayak izlerini takip ederek ilerliyoruz diyebiliriz.

16) 7 milyarlık modeli de açık kaynak yayınlayacak mısınız?

daha büyük ve multimodal modeller ürettikçe 7 milyarlık versiyondan başlayarak eski modelleri yayınlamayı planlıyoruz.

6 favorites - crinix - 10.10.2025 22:47 ~ 11.10.2025 22:04

1 den 1.000.000'a kadar saymasını istedim hala sayıyor. görsel

10 favorites - sf34sf - 10.10.2025 22:55

az çok kodlama bilirim ama yapa zeka falan anlamam.

teknolojiye de hakim değilim.

ama bu ai cümle sonuna "?" yazmadığım için soru sorduğumu anlamadı.

chatgpt anladı

teknolojiye de hakim değilim.

ama bu ai cümle sonuna "?" yazmadığım için soru sorduğumu anlamadı.

chatgpt anladı

2 favorites - gurelk - 10.10.2025 23:12

ne dediğini bilmeyen bir yapay zeka. ama en azından diğerleri gibi arkada chatgpt api kullanmıyor.

2 favorites - kerimdemirkaynak - 11.10.2025 13:17 ~ 13.10.2025 08:36